Product request

You are looking for a solution:

Select an option, and we will develop the best offer

for you

Wozu Video-Codecs gut sind

Codecs kommen bei der Aufzeichnung, Bearbeitung, Bereitstellung und Wiedergabe von Videos zum Einsatz. Ohne diese Technologie könnten Abonnenten von Streaming-Diensten keine Videos abrufen, es wären auch keine Videokonferenzen möglich. Die Aufgabe eines Codecs besteht darin, die Größe von Videodateien zu verringern. Im Folgenden gehen wir darauf ein, wie genau ein Codec funktioniert und warum die Komprimierung von Videos so wichtig ist.

Warum müssen Videos komprimiert werden?

Videodateien benötigen viel mehr Speicherplatz als zum Beispiel Bilder oder Musik. Das liegt unter anderem daran, dass ein Video außer der eigentlichen Videospur auch mindestens eine Audiospur hat und manchmal auch Untertitel enthält. Darüber hinaus enthalten sie Metadaten mit Service-Informationen, die der Synchronisation der Audio- und Videospur dienen.

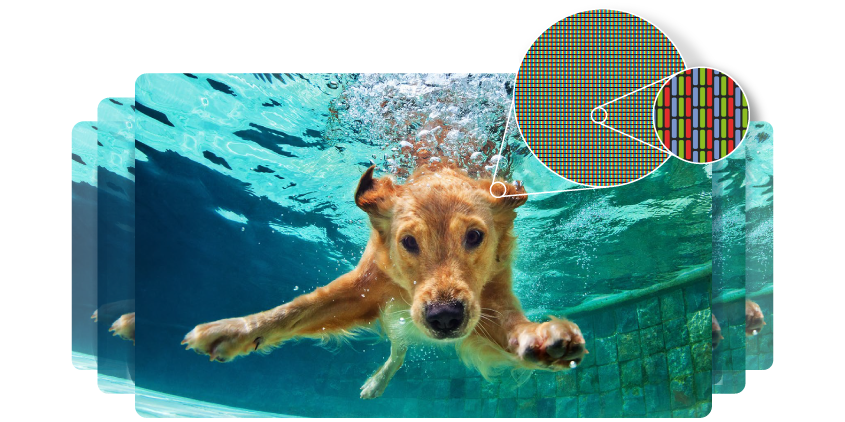

Eine Videospur besteht aus Einzelbildern (Frames), jedes Einzelbild besteht aus Pixeln, und jedes Pixel besteht aus drei Subpixeln: Rot, Grün und Blau. Die Subpixel-Farbdaten bestehen ihrerseits aus 8 Bits (1 Byte). Es werden also 3 Bytes benötigt, um ein einzelnes Pixel in einer von 16 Millionen Farben zu kodieren. In der FullHD-Auflösung hat jedes Frame mehr als 2 Millionen Pixeln. Folglich erfordert ein kompletter Film Hunderte von Gigabytes an Speicherplatz.

Ein Video mit der Laufzeit von 90 Minuten in FullHD-Qualität bei 24 fps würde 750 GB an Speicherplatz einnehmen - und das ohne die Audiospur.

Source: Infomir.store

Für die Speicherung unkomprimierter Videos mit hoher Auflösung bzw. hoher Framerate, wie es zum Beispiel bei 4K (4096×2160) oder 8K (7680×4320) der Fall ist, wird noch mehr Speicherplatz benötigt. Daher ist es unmöglich, mit den gängigen Bandbreiten so große Dateien über das Internet zu übertragen.

Genau an dieser Stelle kommt die Video-Komprimierung zum Einsatz. Mit deren Hilfe kann man den Speicherbedarf optimieren, was das Streaming über Netzwerke erlaubt. Für die Komprimierung kommen viele verschiedene Methoden zum Einsatz: mathematische Algorithmen, Vorausberechnung, Entfernen redundanter Daten, Abrunden absoluter Werte sowie kanalweises Verarbeiten von Farben.

Die Komprimierung wird manchmal auch als Kodierung bezeichnet. Der umgekehrte Prozess wird als Videodekodierung oder Dekomprimierung bezeichnet.

Was Video-Codecs eigentlich sind

Codecs sind Hardware- und Softwaretools für die Videokodierung. Das Wort Codec leitet sich von den englischen Begriffen COder/DECoder ab.

Wenn die Kodierung verlustfrei (lossless) erfolgt, können die Originaldaten vollständig wiederhergestellt werden. Eine solche Komprimierung wird bei der ursprünglichen Aufzeichnung und Nachbearbeitung von Videos verwendet. Allerdings geht das auf Kosten der Komprimierungsrate.

Beim Streaming von Videoinhalten kommt in der Regel eine Komprimierung mit Verlusten zum Einsatz. Auf diese Weise gelangen Videos zu Client-Geräten: Fernsehern, TV-Boxen, Computern und Handys. Je stärker die Komprimierung ist, desto schlechter ist die Videoqualität, aber dadurch wird auch die Dateigröße verringert.

Codecs entfernen redundante Daten auf zwei Ebenen: innerhalb eines Frames und auf der Ebene der Frame-Abfolge.

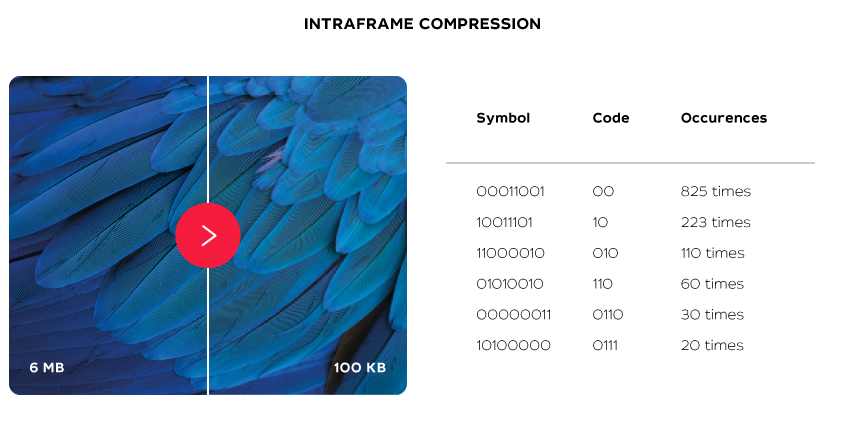

Intraframe-Komprimierung

Bei der Intraframe-Komprimierung verarbeiten die Codecs jedes Frame einzeln. Man kann das mit der Komprimierung von JPEG-Bildern vergleichen. Der Algorithmus teilt das Frame in die Luminanz- und Chrominanz-Komponenten auf, reduziert den Detailgrad und markiert ähnliche Bereiche. Als Ergebnis erhält man eine exponentiell kleinere Datei mit minimalem Qualitätsverlust.

Codecs komprimieren Daten ähnlich wie man Zahlen in der Mathematik kürzen kann: Anstatt 20 Nullen hinzuschreiben, reicht es, ihre Anzahl anzugeben.

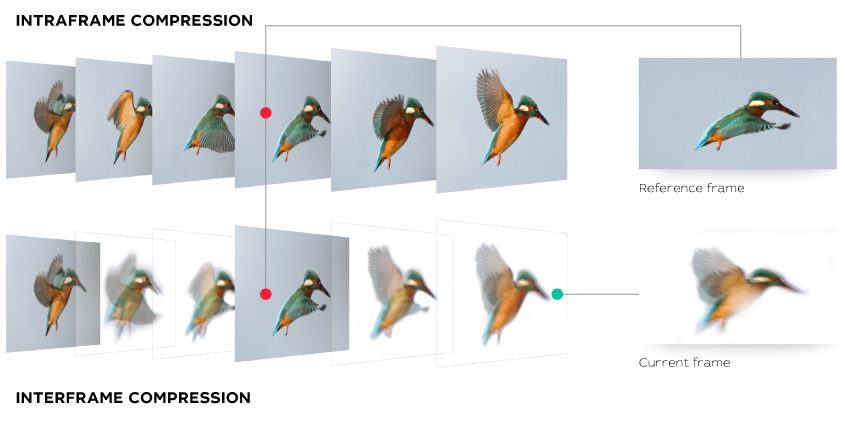

Interframe-Komprimierung

Häufig sehen aufeinanderfolgende Bilder fast identisch aus. Das kann man ausnutzen, um die Daten weiter zu komprimieren. Da solche Bilder nicht in ihrer Gesamtheit erhalten werden müssen, entfernen Codecs alle sich wiederholenden Daten aus dem Bild und lassen nur die Bereiche übrig, die sich unterscheiden. Ähnlich funktionieren auch die Algorithmen für Motion Compensation (Bewegungsausgleich).

Bei der Methode der Interframe-Differenz werden einzelne Frames miteinander verglichen. Das Ergebnis enthält nur die Information über die Unterschiede zwischen den Frames. Motion Compensation basiert auf Vorhersagen: nur die als Referenz genutzen Frames werden vollständig gespeichert, alle Frames dazwischen werden anhand der vorhandenen Informationen vorhergesagt.

Um zu sehen, wie die Interframe-Komprimierung aussieht, drücken Sie einfach bei einem beliebiges Video während einer ereignisreichen Szene auf Pause. Wenn Sie dabei nicht an einem Referenzbild anhalten, werden die Bereiche mit sich bewegenden Objekten unscharf sein. Aber das menschliche Auge kann diese Unschärfe bei normaler Abspielgeschwindigkeit einfach nicht wahrnehmen.

Die Geschichte von Video-Codecs

Die Geschichte der digitalen Videokompression begann 1988 mit der Entwicklung des Codecs H.261. Dieser Codec profitierte von Motion Compensation, Referenzierung der vorherigen Frames, der Farbkompression und dem 8×8 Array Sampling.

Im Jahr 1993 trat MPEG1 in den Vordergrund. Diese Technologie stützte sich auf zukünftige und vorherige Referenz-Frames für die Vorhersage und unterstützte erstmals HD-Video. Der MPEG1-Standard wurde für Videos mit der Auflösung 352×240 entwickelt, konnte aber Auflösungen bis zu 4095×4095 verarbeiten. Allerdings unterstützte MPEG1 nur progressive Abtastung (Progressive Scanning), so dass diese Technologie schon bald durch neue Codecs ersetzt wurde.

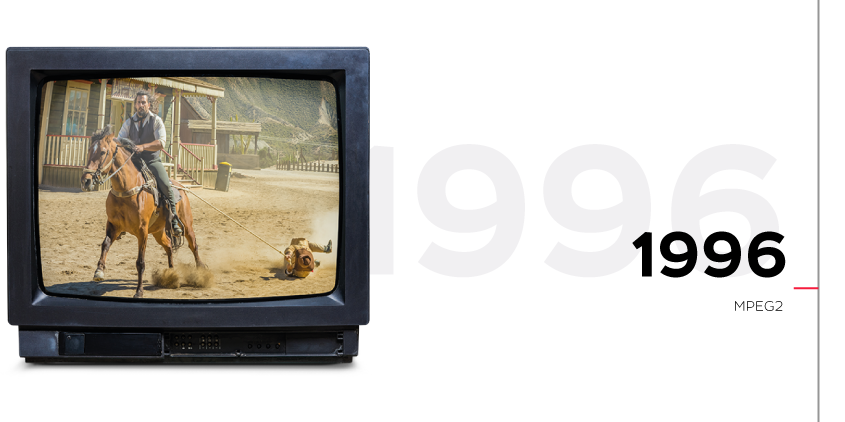

Drei Jahre später kam einer der bekanntesten Video-Codecs auf den Markt – MPEG2. Die Technologie kam sowohl beim digitalen Fernsehen als auch bei DVD zum Einsatz. Dadurch eröffneten sich auch neue Möglichkeiten für Audio-Kodierung, da der Codec Komprimierung von Dateien mit bis zu 6 Audiospuren unterstützte. MPEG2 sorgte für eine hohe Videoqualität, bot aber wenig Möglichkeiten für Komprimierung, da die Technologie für Geräte mit geringer Leistung konzipiert war. Man nutzt MPEG2 auch heute noch, zum Beispiel bei Rundfunkübertragung sowie im Kabel- und Satellitenfernsehen.

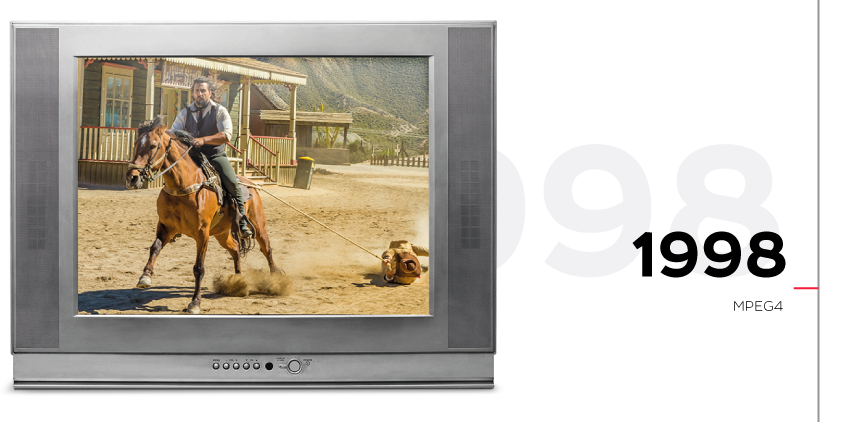

Im Jahr 1998 wurde der neue Standard MPEG4 entwickelt. Mit Hilfe dieses Codecs konnte ein 90-minütiger Film auf eine damals übliche CD gepackt werden. Der Codec konnte sowohl 2D- als auch 3D-Objekte verarbeiten. Er unterstützte auch, DRM mehrere Audiospuren und Untertitel. Dennoch war MPEG4 noch nicht für das Streaming in FullHD geeignet.

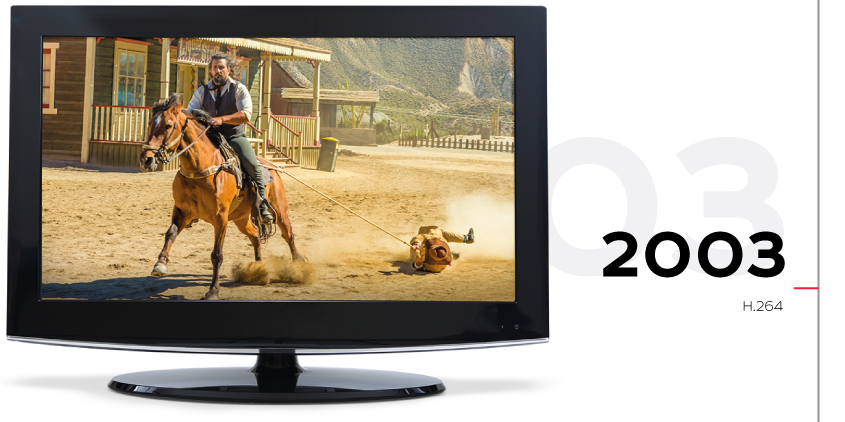

2003 begann die Ära von H.264. Diese Technologie komprimiert Videos doppelt so effizient in Vergleich zu MPEG4. Damit wurde auch die Übertragung von FullHD-Videos über Netzwerke mit Bandbreiten von 5 Mbit/s möglich.

Dieser Codec kommt auch heute häufig zum Einsatz. Aber seine Grenzen zeigen sich, wenn es um die Komprimierung von 4K-Videos geht, insbesondere beim Streaming in mobilen Netzwerken.

Im Jahr 2020 beträgt die durchschnittliche Geschwindigkeit der Datenübertragung 33,7 Mbit/s in Mobilfunknetzen und 76,94 Mbit/s in Kabelnetzwerken. Für die Wiedergabe von 4K H.264 Videos reicht das nicht aus.

Quelle: Speedtest Global Index

Der Codec der Zukunft

Im Jahr 2012 entwickelte die Arbeitsgruppe “Joint Collaborative Team on Video Encoding” den HEVC-Codec (H.265).

Die Technologie baut auf H.264 auf, bietet aber eine doppelt so starke Komprimierung bei gleicher Videoqualität.

HEVC stützt sich zwar auf H.264, bringt aber auch etwas Neues mit sich, zum Beispiel die parallele Verarbeitung. Damit ist es möglich, Bildbereiche gleichzeitig zu verarbeiten.

Der einzige technische Nachteil von H.265 ist der hohe Bedarf an Ressourcen. Für die Kodierung und Dekodierung von Videos wird 3 bis 5 Mal so viel Rechenleistung benötigt wie es bei H.264 der Fall ist. Dieser Codec ist noch nicht so weit verbreitet wie H.264, wird aber bereits von vielen Set-Top-Boxen, Smart-TVs, Smartphones und anderen modernen Geräten unterstützt.

Damit treibt HEVC die Einführung von 4K-Streaming voran. Sein Nachfolger wird der Future Video Codec (FMC) sein. Er könnte zu einem Mittel für die Übertragung von 8K-Videos werden. Die Entwickler versprechen, dass der neue Codec 50 % effizienter bei der Video-Komprimierung ist. Im Oktober 2019 wurde auch ein Entwurf des internationalen Standards für H.266 veröffentlicht. Die ersten Hardware-Codecs waren für Juni 2021 geplant.

Ohne Codecs wäre es nicht möglich, Videodateien zu speichern und bereitzustellen. Neue Technologien der Komprimierung ermöglichen es großen und kleinen Streaming-Betreibern, hochwertige Inhalte anzubieten, ohne ihre Infrastruktur ständig aufrüsten zu müssen. Mit Codecs können Videos in hoher Auflösung selbst über vergleichsweise langsame Internetverbindungen gestreamt werden. Eine Bandbreite von 15 Mbit/s reicht zum Beispiel aus, um Filme in 4K auf Netflix anzusehen.

Recommended

Künstliche Intelligenz im IPTV: Verbesserung der Personalisierung und Benutzererfahrung

Digitalfernsehen und IPTV: Welche Abonnements und Tarife eignen sich für verschiedene Zielgruppen?

In einem zunehmend wettbewerbsintensiven Markt für digitales Fernsehen ist die Gestaltung gut strukturierter und attraktiver Tarifpläne entscheidend für die Gewinnung und Bindung von Abonnentinnen und Abonnenten. IPTV-Anbieter müssen ihre Preisstrategien und Servicepakete gezielt auf unterschiedliche Kundengruppen ausrichten und dabei Flexibilität, Erschwinglichkeit und Kundenzufriedenheit sicherstellen. Dieser Artikel beleuchtet verschiedene Abonnementmodelle, ihre Vorteile und Best Practices zur Gestaltung von IPTV-Tarifplänen, um Einnahmen zu maximieren und die Benutzerzufriedenheit zu steigern.